* Importante: Todos los experimentos se hicieron en inglés.

A ver, te cuento. Escribí todo este blog sobre un coach ejecutivo de IA con el que estuvimos experimentando y pensé: “Cualquiera que lea esto seguramente lo va a querer probar antes”.

¡No te lo pierdas! No es perfecto, pero es bastante entretenido. (Tenemos que pagar por el uso de tókenes, así que no te quedes charlando toda la noche). Vamos a dejar las suscripciones abiertas unos días.

Cuando termines de charlar, regresa y lee el resto del artículo. Y ahí volveremos a nuestra programación habitual:

Sí, los robots hablan.

OpenAI anunció el 13 de mayo que, en las próximas semanas, lanzará un nuevo modo conversacional.

Con la generalización de estas funcionalidades mejoradas, hablar con la IA se transformará en nuestra manera habitual de interactuar con la tecnología. ¿Y qué significa esto para el aprendizaje y desarrollo? ¿Cómo llegamos hasta aquí? A fin de cuentas, los asistentes de voz no son ninguna novedad. ¿Por qué tanto alboroto?

Hicimos algunos experimentos para averiguarlo y, entre tanto, recabamos la opinión de varios profesionales de Aprendizaje y Desarrollo. Acompáñanos a ver los resultados y sus consecuencias. Todo parece indicar cada vez más que la IA conversacional afectará en gran medida algunos aspectos clave del aprendizaje y desarrollo.

Primero, un breve resumen tecnológico

Los asistentes de voz, como Siri de Apple y Alexa de Amazon, ya existen desde hace bastante. Usan procesamiento del lenguaje natural (o NLP, por su sigla en inglés) para recibir solicitudes y asociarlas con respuestas predeterminadas. O sea, sirven para consultar cómo va a estar el tiempo; pero por otra parte, como observó en 2023 el director ejecutivo de Microsoft, Satya Nadella, son “muy tontos”. No tienen las capacidades dinámicas ni generativas de los grandes modelos de lenguaje (o LLM, por su sigla en inglés) como el que usa ChatGPT.

ChatGPT cambió las reglas del juego. En 2022, se presentó Whisper como complemento para ChatGPT-3.5 y les dio a los usuarios la posibilidad de convertir audio en texto. De esta manera, los usuarios empezaron a hablarle a ChatGPT, que luego podía leer las respuestas si hacían clic en un botón. Se agregó la funcionalidad de audio y voz, pero a la tecnología todavía le faltaba la capacidad de interrumpir, ser interrumpida o mantener una conversación real sin la instrucción estricta de turnarse.

Con los LLM, las empresas emergentes más nuevas permiten interacciones más conversacionales. Incorporaron la posibilidad de detectar de forma automática los turnos de diálogo, de modo que haya interrupciones y ambas partes puedan hablar libremente. Además, agregaron simpáticas interjecciones (como “ajá”) que se oyen mientras la IA escucha. También analizaron expresiones vocales. En estas experiencias hubo un poco de latencia, ya que ineludiblemente es un proceso de varios pasos. Un LLM, como ChatGPT-4, genera una respuesta y luego un agente de voz (otra tecnología) la dice en voz alta.

Este mes, OpenAI anunció que ChatGPT-4o, la versión más reciente de su chatbot de IA generativa, será capaz de entender y dar respuestas como si estuviera en una conversación. Es decir, no habrá más un agente de voz que lea las respuestas del LLM, el cual hablará por sí mismo. Si le dijéramos a la IA que “hable más lento” o “haga de cuenta que es un personaje”, lo hará. Además, tendrá más expresividad vocal natural y comprenderá las expresiones vocales de los usuarios. Como todo estará incorporado en el mismo sistema, será más rápido que cualquier innovación anterior.

Hasta la fecha, solo hay un modelo de GPT-4o de texto. Las funcionalidades de voz más avanzadas (entre ellas, una controvertida voz muy parecida a la de Scarlett Johansson) no se lanzaron hasta el momento de esta publicación. Por eso, hoy, en este preciso instante, puedes hablar con GPT-4o, que es rápido, pero tienes que avisarle al sistema si quieres interrumpirlo (porque todavía usa la tecnología anterior de voz y lectura). Puedes consultar más detalles de la versión disponible actualmente.

Si inicias sesión hoy, seguramente veas una pantalla similar a esta cuando inicies el modo de voz en ChatGPT:

¡Uf, cuánta información! Hablemos de qué repercusiones puede tener todo esto para Aprendizaje y Desarrollo cuando se abran las compuertas.

Nuestra hipótesis: interacciones más rápidas y auténticas para practicar y reflexionar

Ya habíamos analizado el uso de situaciones por chat (con escritura) como método de práctica y dramatización. Al principio, estas interacciones eran divertidas, pero el esfuerzo necesario para que parecieran reales (cuando los usuarios sabían que se trataba de una IA) era difícil de sostener. Además, era raro representar por chat situaciones que normalmente se dan en conversaciones orales (como una llamada).

Queríamos agregar funcionalidades de voz para ver si la situación podía parecer más real, de modo que resultara más fácil interactuar.

Primer experimento: coach de IA

Usamos GPT-4 Turbo como LLM y le agregamos una capa conversacional. Luego, le indicamos a la asistente que actuara como coach ejecutiva. De acuerdo con investigaciones anteriores, GPT-4 es el modelo más eficaz para dramatizaciones (teniendo en cuenta una evaluación limitada de otros modelos).

En este video, registré mi primera experiencia con esta combinación:

Como verás, hay un poco de latencia, pero la capacidad conversacional es asombrosa. Al que más le cuesta enhebrar las palabras es a mí.

Compartí el enlace para que mis colegas de Aprendizaje y Desarrollo probaran la coach de IA y me dieran su opinión.

En general, las apreciaciones fueron positivas:

- “Natural”.

- “¡Guau!”.

- “¡Increíble!”.

- “Realista”.

- “Fluido”.

- “Me imagino usándola a diario”.

- Después está la reacción de mi esposa: “La verdad, da un poquito de miedo”.

Comentarios sobre la interacción mediante voz:

- La fluidez de la conversación es muy buena y la más parecida a la humana hasta ahora.

- La voz es útil para reflexionar. La gente es menos autocrítica con la voz porque es lineal (no se puede volver atrás ni hacer correcciones) y no ve el registro de lo que dice. Hablar es más rápido y requiere menos esfuerzo.

- Cuando se le pidió a la coach que hablara más lento (para tratar de tomar nota de las recomendaciones), no pudo.

- Los usuarios sabían que era una IA, pero con el tiempo iban perdiendo la noción.

- El tono y las inflexiones eran buenas y coloquiales.

- La latencia se notaba, pero según dijeron, no era demasiada.

Comentarios sobre la utilidad de la coach de IA:

- La coach sugirió ideas y recomendaciones útiles.

- Dio lugar a reflexiones reales porque hace buenas preguntas.

- A los usuarios les pareció que el abordaje y la metodología eran eficaces.

- La coach suele repetir lo que dijo el usuario (detalle que se consideró tanto positivo como negativo).

- Sugirió una dramatización para poner en práctica la recomendación, lo que resultó oportuno, pero la dramatización en sí fue un poco torpe.

Comentarios sobre la interfaz para los usuarios:

- Hace falta alguna función para tomar nota de las recomendaciones (se mencionó varias veces).

- No era muy evidente cómo había que iniciar la conversación.

- Quizás sería conveniente que haya un avatar (para sentir que uno habla con alguien).

- Hace falta una función para hacer una pausa (para reflexionar o simplemente hacer otra cosa).

- Debería indicar cuánto va a durar la experiencia.

- Sería útil ver una transcripción, un resumen, las medidas para tomar o los recursos para consultarlos en otro momento.

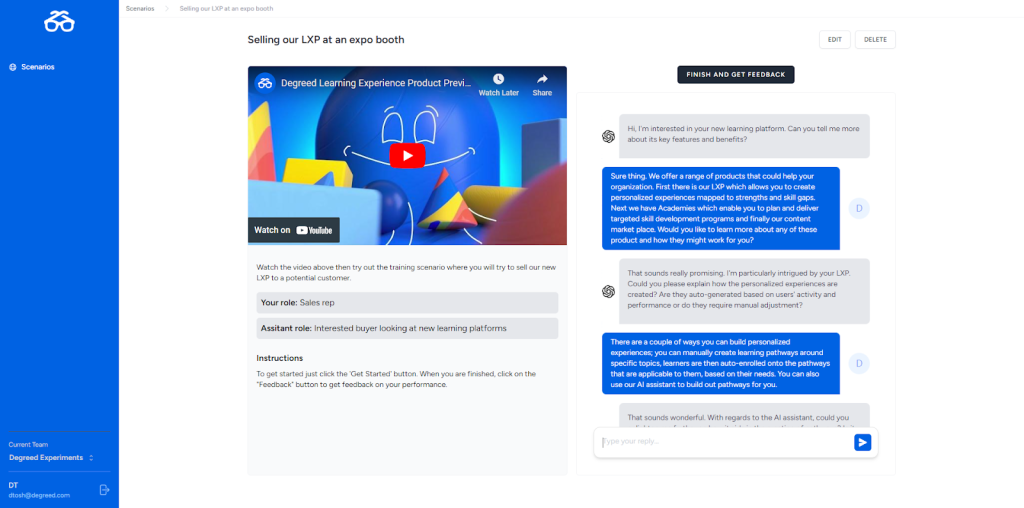

Segundo experimento: dramatización de IA con comprensión de expresiones

En este experimento, queríamos ver si la comprensión de las expresiones y las interacciones con la IA parecían naturales. Experimentamos con una dramatización en la que ayudamos a un cliente enojado a resolver un problema con el servicio de atención.

Aquí te dejo un pequeño fragmento:

Todavía no recibimos muchas opiniones sobre esta experiencia, pero estas son mis primeras impresiones. La dramatización resultó eficaz porque logró hacerme sentir incómodo. Fue difícil y estresante. Sentí cierto grado de “autenticidad” al escuchar la voz angustiosa de otra persona.

Pero como sabía que era una simple dramatización, era consciente de que podía dejarla en cuanto me sintiera trabado o incómodo. Necesitaría algún tipo de obligación de rendir cuentas o evaluación para perseverar. Por otra parte, aprendí que no tengo madera para trabajar en atención al cliente.

Le pedí a uno de nuestros líderes de Ventas que probara esta interacción y dijo que habló 15 minutos con el cliente de IA hasta llegar a una buena resolución. (Hubo que cambiar de táctica a mitad de camino). Según él, sentía que tenía que resolver el problema para poder “ganar”. En fin, los vendedores tienen una forma de ser peculiar.

También probamos una interacción de coaching con una IA que comprende expresiones para ver si podía detectar mi emoción sin depender del contenido de mis palabras. Si bien me impresionó que captara mi actitud (aunque no se reflejara en mis palabras), no me convenció. Tal vez porque yo estaba compenetrado con la prueba, me resultó artificial que la IA actuara como si entendiera mis sentimientos. Además, no logró detectar cuándo entrar en la conversación e interrumpió constantemente mis divagaciones de descontento.

Conclusión: el análisis de expresiones seguramente sea más útil para las interacciones reales entre humanos.

Tercer experimento: más velocidad con GPT-4o

Cuando surgió el modo de texto con GPT-4o, decidimos volver a probar la coach de IA que habíamos creado para el primer experimento. Según lo publicitado, el modo de texto es un 50 % más rápido que GPT-4 Turbo, así que nos pareció una excelente manera de ver si podíamos bajar la latencia.

La inclusión de GPT-4o en la coach de IA redujo un poco la latencia, como puedes ver aquí:

Conclusión: con GPT-4o, la latencia de nuestra aplicación de coach con IA se redujo de un promedio de 3,6 segundos a 2,2 segundos, por lo que la conversación fue mucho más natural.

De cara al futuro

No terminamos de experimentar con la voz. Implementaremos algunas de las sugerencias que ya recibimos de los colegas de Aprendizaje y Desarrollo para la coach de IA (como la inclusión de transcripciones, el resumen de las medidas para tomar, una mejor interfaz para los usuarios, análisis y opciones de comentarios).

Seguiremos evaluando los LLM más recientes. También investigaremos el uso de voz para otros casos (tal vez algo para usar en equipos móviles, algo con lo que se interactúe en reuniones o que ayude a hacer tareas administrativas).

Aquí te dejo un ejemplo de las transcripciones en tiempo real:

Aportes para Aprendizaje y Desarrollo

A medida que surgen más avances en la tecnología de consumo, aumenta la presión para las experiencias que debe brindar el personal de Aprendizaje y Desarrollo. Teniendo esto en cuenta, ¿qué consecuencias tiene el advenimiento de la IA de voz conversacional para los profesionales de Aprendizaje y Desarrollo?

- La IA de voz no sirve para todo, pero parece adaptarse bien a ciertos casos de uso (como el desarrollo de habilidades). Descubre cuáles son esos casos para tu público destinatario y encuentra soluciones acertadas.

- La IA de voz permitirá que Aprendizaje y Desarrollo llegue a un público más amplio con mejores experiencias a un precio menor, pero es probable que eso también aumente el costo de las interacciones reales entre seres humanos.

- Desde luego, para que un coaching resulte eficaz, se necesita mucho más que lo observado en nuestro experimento. No obstante, creemos que las interacciones de IA son un excelente complemento para los programas de aprendizaje.

- GPT-4o podrá encargarse de la mayoría de las tareas pesadas, pero el área de Aprendizaje y Desarrollo seguramente necesitará un proveedor que le brinde informes y análisis, además de conexiones con procesos de trabajo complementarios.

Si quieres hablar sobre IA conversacional, envíame un mensaje a tblake@degreed.com.

¡Gracias por experimentar con nosotros!