* Bitte beachten: Alle Experimente wurden in englischer Sprache durchgeführt.

Vorab ein wichtiger Hinweis: In diesem Blogartikel dreht sich alles um einen KI-gestützten Coach für Führungskräfte, mit dem wir derzeit experimentieren. Es lohnt sich daher, ihn zuerst auszuprobieren, bevor Sie hier weiterlesen.

Hier geht’s zum Coach! Er ist zwar nicht perfekt, aber durchaus unterhaltsam. (Uns fallen Kosten für die Token-Nutzung an, daher wäre es schön, wenn sich Ihr Gespräch mit ihm nicht gleich auf mehrere Stunden auswächst.) Wir haben die Anmeldung zeitlich befristet, allerdings steht sie Ihnen noch einige Tage offen.

Nachdem Sie den Coach ausprobiert haben, können Sie ja zu diesem Artikel zurückkommen. Und damit weiter im Text:

Es ist wahr, die Roboter haben Sprechen gelernt!

OpenAI gab am 13. Mai bekannt, in den nächsten Wochen mit einem neuen Dialogmodus an den Start zu gehen.

Damit werden noch ausgefeiltere Fähigkeiten verfügbar, die den verbalen Austausch mit KI selbstverständlich machen werden. Was aber bedeutet das für L&D? Und warum beschäftigt uns das überhaupt? Schließlich sind Sprachassistenten längst nichts Neues mehr. Oder ist hier jetzt alles anders?

Um das herauszufinden, haben wir ein wenig experimentiert und dabei auch die Einschätzungen von L&D-Fachleuten eingeholt. Die Ergebnisse erläutern wir im Folgenden, ebenso wie die Auswirkungen, die damit einhergehen. Denn wie sich zunehmend abzeichnet, wird dialogorientierte KI einen ganz erheblichen Einfluss auf einige zentrale Aspekte von L&D nehmen.

Zunächst ein kurzer Überblick zur Technologie

Sprachassistenten wie Apple Siri oder Amazon Alexa gibt es schon seit einiger Zeit. Durch die Verarbeitung natürlicher Sprache verarbeiten sie Anfragen und geben dazu passende, vorgefertigte Antworten aus. So können sie zwar die Wettervorhersage verkünden, doch wie es Microsoft CEO Satya Nadella 2023 ausdrückte, sie sind auch „dumm wie ein Stein“. Es fehlt ihnen an den dynamischen oder generativen Fähigkeiten, die ein Large Language Model (LLM) wie das von ChatGPT bietet.

ChatGPT brachte dann auch die echte Veränderung: Mit Whisper, das 2022 als Ergänzung zu ChatGPT-3.5 eingeführt wurde, ließ sich Audio in Text umwandeln. So wurde es möglich, ChatGPT Sprachanweisungen zu geben und sich per Mausklick die Antworten vorlesen zu lassen. Audiofunktionen und Spracheingaben machten die Technologie zwar nutzbar, doch konnte sie die Ausgabe nicht unterbrechen oder dabei unterbrochen werden und war nicht zu einem echten Gespräch in der Lage, bei dem es keine strikten Anweisungen dafür braucht, wann wer etwas sagt.

Danach führten Start-ups aufbauend auf LLMs weitere Entwicklungen ins Feld, die einen natürlicheren Dialog ermöglichten. Wer im Gespräch an der Reihe ist, erkannten die Lösungen automatisch und ließen Unterbrechungen zu, sodass tatsächlich ein Dialog möglich wurde. Ergänzt wurde dies zudem um auflockernde Zwischenrufe wie „mhm“, mit denen die KI signalisiert, dass sie zuhört. Auch Betonung und Tonfall wurden analysiert, wobei all dies mitunter mit Latenzen verbunden war, da der zugrunde liegende Prozess mehrere Schritte beinhaltete: Zunächst generiert ein LLM wie ChatGPT-4 die Antwort, die dann von einem Sprachagenten und damit einer separaten Technologie gesprochen wird.

Diesen Monat gab OpenAI bekannt, dass ChatGPT-4o, die neueste Version seines generativen KI-Chatbots, in der Lage sein werde, Dialoge nativ zu verstehen und darauf zu antworten. Es braucht also keinen Sprachagenten mehr, der die Antworten des LLM vorliest. Das LLM spricht eigenständig: Fordert man die KI auf, langsamer zu sprechen oder eine bestimmte Rolle einzunehmen, wird sie dies tun. Ihrer Stimme wird dabei Ausdrucksstärke verliehen, und die KI wird den stimmlichen Ausdruck ihres Gegenübers verstehen können. All dies wird zudem in ein und dasselbe System integriert. Dadurch wird es schneller sein als alles bislang Dagewesene.

Zum Zeitpunkt der Veröffentlichung dieses Artikels ist nur das textbasierte Modell von GPT-4o verfügbar; die hochmodernen Sprachfunktionen (darunter auch eine umstrittene, der Schauspielerin Scarlett Johansson ähnelnde Stimme) wurden noch nicht veröffentlicht. Gegenwärtig ist es also möglich, ein Gespräch mit GPT-4o zu führen, doch muss man dem System mitteilen, wenn man es unterbrechen will, da es noch die frühere Technologie zur Spracheingabe und -ausgabe verwendet. Welche Funktionen aktuell verfügbar sind, können Sie hier nachlesen.

Zum Zeitpunkt der Veröffentlichung dieses Artikels wird in ChatGPT folgender Bildschirm angezeigt, wenn Sie den Sprachmodus aufrufen:

Gut, das war jetzt doch etwas länger als gedacht. Kommen wir nun also dazu, was die Verfügbarkeit von all dem für L&D bedeuten könnte.

Unsere Hypothese: Schnellere und authentischere Interaktionen für praktische Übungen und Reflexion

Mit textbasierten Chat-Szenarien für praktische Übungen und Rollenspiele hatten wir zuvor bereits experimentiert. Anfangs waren diese Interaktionen zwar unterhaltsam. Zu gewährleisten, dass sie sich real anfühlten (obwohl natürlich klar war, dass es sich um eine KI handelte), war aber letztlich mit einem viel zu großen Aufwand verbunden. Zudem erwies es sich als unnatürlich, Szenarien wie etwa ein Telefonat in einem Chat durchzuspielen, die eher in gesprochener Sprache stattfinden würden.

Um das Gefühl realer Interaktionen zu vermitteln und den Austausch einfacher zu gestalten, wollten wir das Szenario daher um Sprachfunktionen ergänzen.

Experiment 1: KI-Coach

Als LLM verwendeten wir GPT-4 Turbo, das wir um eine Ebene zur Sprachkommunikation erweiterten. Dann wiesen wir den Assistenten an, als Coach für Führungskräfte zu agieren. Zu bemerken ist hier, dass sich GPT-4 im Rahmen von früheren Forschungsarbeiten als effektivste Lösung für Rollenspiele erwiesen hat (wobei die Evaluierung eine begrenzte Auswahl anderer Modelle umfasste).

In diesem Video sind meine ersten Erfahrungen mit dieser Kombination festgehalten:

Zwar ist hier eine gewisse Latenz festzustellen. Die Fähigkeiten zur Gesprächsführung sind jedoch beeindruckend – tatsächlich bin ich derjenige, dem es schwerer fällt, sich klar auszudrücken.

Um Feedback von anderen einzuholen, ließ ich den KI-Coach von L&D-Verantwortlichen in meinem Netzwerk testen.

Insgesamt fiel die Resonanz äußerst positiv aus:

- „Sehr natürlich.“

- „Beeindruckend!“

- „Fantastisch!“

- „Echt realistisch.“

- „Leichtgängig.“

- „Das könnte ich mir auch für den täglichen Einsatz vorstellen.“

- Gut, meine Frau sah das etwas anders. Sie fand das Ganze „echt bizarr“.

Zur sprachbasierten Interaktion erhielt ich folgende Kommentare:

- Ein sehr guter Gesprächsfluss, der aktuell am ehesten an die Interaktion mit Menschen herankommt.

- Sprachbasierte Interaktion eignet sich gut zur Reflexion; man ist dabei weniger selbstkritisch, weil das Gespräch linear abläuft (man also keine nachträglichen Änderungen mehr vornehmen kann) und nicht sichtbar ist, was man eingegeben, also gesagt hat. Mein Eindruck: Das Ganze lief schneller und war unkomplizierter.

- Als ich den Coach anwies, langsamer zu sprechen (damit ich seine Empfehlungen aufschreiben konnte), war er dazu nicht in der Lage.

- Auch wenn natürlich klar war, dass mein Gegenüber eine KI ist, fühlte sich das im Gesprächsverlauf zunehmend weniger danach an.

- Die Betonung und Artikulation waren gut und einem natürlichen Gespräch ähnlich.

- Die Latenz war zwar spürbar, fiel aber nicht allzu negativ auf.

Zum Nutzen des Coaches gab es folgende Anmerkungen:

- Der Coach lieferte hilfreiche Ideen und Empfehlungen.

- Er stellte gute Fragen, die wirklich zum Nachdenken anregten.

- Ansatz und Methodik wurden als effektiv bewertet.

- Der Coach hat die Angewohnheit, das Gesagte seines Gegenübers zu reflektieren (was von einigen als positiv, von anderen als negativ empfunden wurde).

- Zur praktischen Übung der Empfehlung schlug er ein Rollenspiel vor. Das war zwar angemessen, doch das Rollenspiel selbst fühlte sich etwas unbeholfen an.

Zur UI fielen die Kommentare wie folgt aus:

- Eine Möglichkeit zur Dokumentation der Empfehlungen wäre wichtig (wurde mehrfach erwähnt).

- Es war nicht auf Anhieb klar, wie man das Gespräch beginnt.

- Ein Avatar wäre hilfreich, damit man das Gefühl hat, mit einer Person zu sprechen.

- Man sollte Pausen einlegen können (zum Nachdenken oder um kurz andere Dinge zu erledigen).

- Es muss kommuniziert werden, wie viel Zeit das Szenario in Anspruch nehmen wird.

- Hilfreich wäre eine Mitschrift, eine Zusammenfassung, die Anzeige der nächsten Schritte oder von Ressourcen, auf die man später zurückgreifen kann.

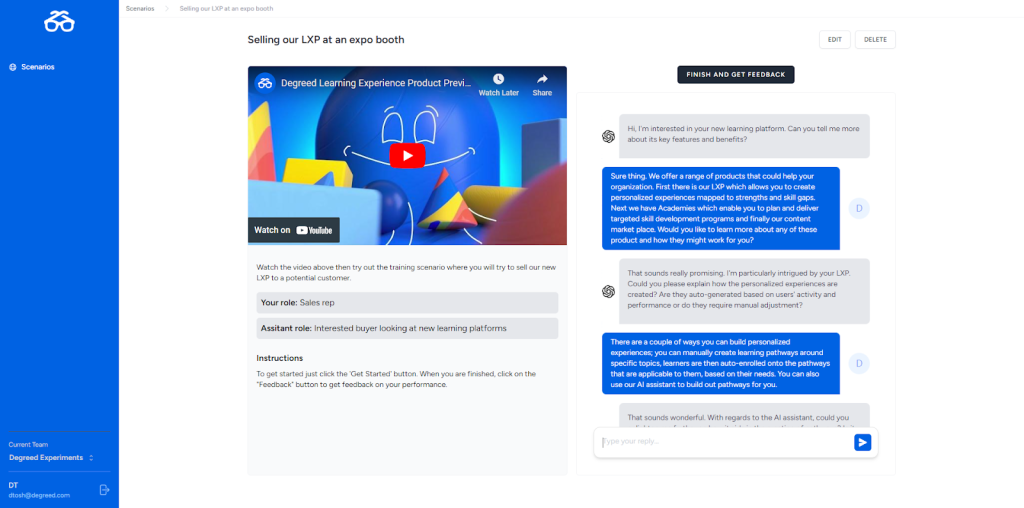

Experiment 2: KI-Rollenspiel zum expressiven Verständnis

Hierbei untersuchten wir, inwieweit sich das expressive Verständnis und Interaktionen mit der KI natürlich anfühlen würden. Für das Experiment wählten wir ein Rollenspiel, bei dem ein verärgerter Kunde beim Service anruft, dem wir bei der Lösung seines Problems helfen müssen.

Nachfolgend ein kurzes Video dazu:

Zu diesem Szenario haben wir noch nicht allzu viel Feedback erhalten. Mein persönlicher Eindruck war jedoch, dass das Rollenspiel insofern effektiv war, als ich mich dabei reichlich unwohl gefühlt habe. Es war anspruchsvoll und ziemlich anstrengend. Die aufgebrachte Stimme einer anderen Person zu hören, ließ das Ganze in gewisser Weise „echt“ wirken.

Nachdem das nur ein Rollenspiel war, wusste ich natürlich, dass ich einfach hätte aussteigen können, wenn ich nicht weiter gewusst oder mich unwohl gefühlt hätte. Um das durchzuhalten, müsste ich wohl ein gewisses Maß an Verantwortung für das Ergebnis tragen oder meine Leistung müsste beurteilt werden. Jedenfalls wurde mir dabei klar: Für eine Rolle im Kundenservice bin ich nun wirklich nicht gemacht.

Eine Führungskraft aus unserem Vertrieb ließ ich ebenfalls auf dieses Rollenspiel los. Im Gespräch mit dem KI-Kunden benötigte sie nach eigenen Angaben 15 Minuten, bis sie zu einer guten Lösung gelangt war – wobei sie nach der Hälfte der Zeit ihre Taktik ändern musste. Sie berichtete mir zudem, dass sie den Ansporn verspürte, das Problem zu lösen, um zu „gewinnen“. Offenbar gehen die Leute vom Vertrieb solche Dinge einfach etwas anders an.

Bei einer weiteren Coaching-Interaktion untersuchten wir, ob eine KI mit einem expressiven Verständnis in der Lage ist, meine Emotionen zu erkennen, ohne sich auf den Inhalt meiner Worte zu stützen. Beeindruckenderweise gelang ihr dies, obwohl ich meine Emotionen nicht in entsprechenden Worten ausdrückte, doch wirklich überzeugen konnte mich ich das Ergebnis nicht. Grund hierfür war vielleicht, dass ich mich im Testmodus befand. Zumindest in diesem wirkte die Art, wie die KI auf meine Emotionen einging, nicht authentisch. Auch erkannte sie nicht besonders gut, wann sie aktiv in das Gespräch eingreifen sollte: Bei meinen unzufriedenen Ausführungen unterbrach sie mich wiederholt.

Unter dem Strich lässt sich festhalten, dass die Analyse expressiver Sprache vermutlich eher für echte zwischenmenschliche Interaktionen relevant ist.

Experiment 3: Schnellere Verarbeitung mit GPT-4o

Als der Textmodus von GPT-4o verfügbar wurde, beschlossen wir, unseren KI-Coach aus Experiment 1 erneut zu testen. Der Textmodus soll 50 % schneller sein als der von GPT-4 Turbo. Wir wollten wissen, ob sich dies in der Latenz unseres KI-Coaches niederschlagen würde.

Wie das nachfolgende Video zeigt, wurde die Latenz unseres KI-Coaches durch GPT-4o tatsächlich etwas verringert:

Unser Fazit: Mit GPT-4o konnten wir die Latenzzeit unserer KI-Coach-Anwendung von durchschnittlich 3,6 Sekunden auf 2,2 Sekunden reduzieren, wodurch das Gespräch wesentlich natürlicher wurde.

Ausblick

Auch weiterhin werden wir mit Dialogfunktionen experimentieren. Aktuell setzen wir einige Anregungen der L&D-Fachleute um, die den KI-Coach getestet haben. Zu nennen sind hier etwa Transkriptionen des Gesprächs, eine Zusammenfassung von Aktionspunkten, Verbesserungen an der UI sowie bei Analysen und Feedback-Optionen.

Ebenfalls testen wir weiterhin die neuesten LLMs und untersuchen den Einsatz sprachgesteuerter Interaktionen bei neuen Anwendungsfällen. Denkbar wäre hier etwa die Nutzung in mobilen Szenarien, bei der Interaktion während Meetings oder als Unterstützung bei administrativen Aufgaben.

Hier ein kurzer Einblick dazu, wie wir eine Live-Transkription implementieren möchten:

Kernpunkte für L&D-Teams

Je schneller sich die Technologie für Endverbraucher weiterentwickelt, umso größer wird der Druck für L&D, ebenso fortschrittliche Lernerfahrungen zu gestalten. Wie ist die Einführung dialogorientierter KI vor diesem Hintergrund also für L&D-Verantwortliche zu bewerten?

- Für alles ist dialogorientierte KI sicherlich nicht geeignet, bei bestimmten Anwendungsfällen etwa im Bereich der Skillentwicklung ist sie aber durchaus nützlich. Prüfen Sie daher, was für Ihre Zielgruppen am besten funktioniert, und ermitteln Sie dazu passende Lösungen.

- Dialogorientierte KI kann dabei helfen, mehr Personen mit besseren L&D-Erfahrungen zu geringeren Kosten zu erreichen. Wahrscheinlich ist aber auch, dass in diesem Zuge echte zwischenmenschliche Interaktionen kostspieliger werden.

- Für ein wirklich gutes Coaching braucht es zweifelsohne mehr als das, was wir in unserem Experiment gemacht haben. Dennoch sind wir überzeugt, dass KI-gestützte Interaktionen eine durchaus adäquate Ergänzung zu Ihren Lernprogrammen darstellen können.

- Die Kernaufgaben kann GPT-4o zwar beinahe komplett übernehmen. Einen Anbieter, der Funktionen für Berichte und Analysen liefert und die Anbindung an ergänzende Workflows ermöglicht, werden L&D-Teams aber wohl weiterhin benötigen.

Sie möchten sich noch eingehender über dialogorientierte KI austauschen? Dann senden Sie mir einfach eine E-Mail an tblake@degreed.com.

Wir schätzen Ihre Experimentierfreude und bedanken uns für Ihr Interesse.